1. 이미지 리트리버(Image Retrieval)

- 이미지 리트리버는 주어진 입력(쿼리 / Query)와 유사한 이미지를 대규모 이미지 데이터베이스에서 검색해내는 시스템을 말합니다.

- 이때 입력(쿼리)는 텍스트, 이미지 등 다양하게 활용할 수 있습니다.

- 이미지 리트리버의 주요 구성요소는 아래와 같습니다.

1) 쿼리 입력(Query Input)

* 텍스트 쿼리 : 사용자가 텍스트로 이미지의 설명을 제공하면, 시스템은 이 텍스트를 기반으로 검색을 합니다.

ex. "강아지가 뛰어노는 사진" 이라는 텍스트 쿼리를 입력하면 아래와 같이 쿼리에 해당하는 이미지가 반환되게 됩니다.

* 이미지 쿼리 : 사용자가 이미지를 제공하면, 시스템은 이 이미지와 유사한 이미지를 검색하게 됩니다.

(이를, 콘텐츠 기반 이미지 검색(Content-Based Image Retrieval / CBIR)이라고 부릅니다.)

2) 특징 추출(Feature Extraction)

* 이미지나 텍스트에서 중요한 정보를 추출하여, 이를 벡터 형태의 고차원 공간에 매핑하는 과정을 말합니다.

* 이미지 특징은 색상 히스토그램, 텍스처, 모양, 또는 고차원 임베딩을 의미하고, 텍스트 특징의 경우 텍스트 임베딩을 위한 모델(Word2Vec, BERT, CLIP)을 사용하여 텍스트의 의미적 표현을 벡터로 변환하는 것을 말합니다.

3) 유사도 계산(Similarity Calculation)

* 쿼리와 데이터베이스 내의 이미지 간의 유사도를 계산합니다. 일반적으로, 코사인 유사도 또는 유클리디안 거리 등을 활용합니다. 이를 기준으로 결과를 정렬해 유사도가 높은 순서대로 출력합니다.

4) 결과 반환(Result Retrieval)

* 유사도가 높은 상위 N개의 이미지를 변환합니다. 이는 사용자의 쿼리에 가장 적합한 이미지들로 구성됩니다.

- 이러한 이미지 리트리버는 전자상거래 / 소셜 미디어 / 디지털 자산 관리 / 의료 이미지 분석 등에 활발하게 활용되고 있습니다.

2. CLIP 을 활용해 이미지 리트리버 구현

- 이번에는 CLIP이라는 방법론을 활용해 이미지 리트리버를 구현해보겠습니다.

- CLIP에 대한 설명

* CLIP은 Contrastive Language-Image Pre-training의 줄임말로, OpenAI에서 개발한 멀티모달 AI 모델로, 텍스트와 이미지를 동시에 학습하여 두 가지 입력 간의 연관성을 학습하는 모델을 말합니다.

* 텍스트 인코더와 이미지 인코더가 존재하며, 대조 학습(Contrastive Learning)을 활용해 텍스트 - 이미지 쌍을 학습하고 올바른 이미지 쌍을 구분하도록 해줍니다.

- 이러한 CLIP을 바탕으로 이미지 리트리버를 구현해보겠습니다.

- 학습에 활용할 데이터는 COCO 데이터셋의 소규모 샘플입니다.

먼저 학습에 필요한 라이브러리와 소규모 데이터 샘플을 다운로드 받아줍니다.

이후 사전 학습된 clip을 받아준 뒤, 사용할 데이터를 활용해 Inference만 진행해주겠습니다.

CLIP은 ViT-B/32를 Backbone으로 하겠습니다.

이를 활용해 Inference에 활용될 10개의 이미지와 설명(annotation)에 대해 진행한 결과는 아래와 같습니다.

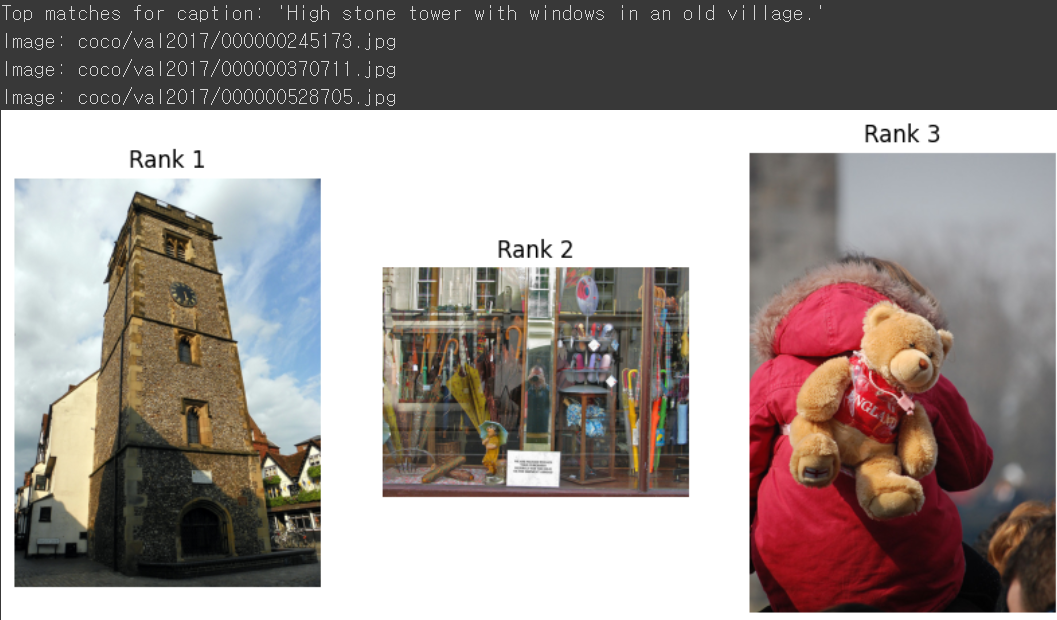

먼저 "High stone tower with windows in an old village" 라는 Query에 대한 이미지를 가져온 결과 입니다.

Rank는 쿼리인 텍스트와 결과인 이미지 간의 유사도 순위를 의미하며, 가장 높은 순위를 보여준 이미지가 실제 텍스트와 유사한 결과를 가지고 있습니다.

- 다음은 A brown and whit vase with foliage on a small table 이라는 쿼리에 대한 결과입니다.

꽤나 정확한 예측을 한 것을 알 수 있습니다.

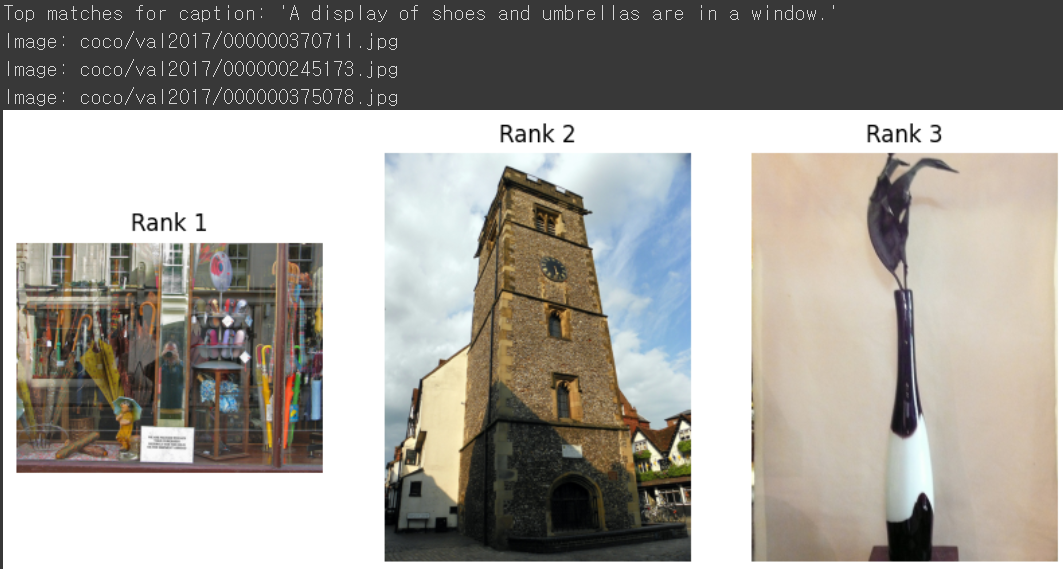

* 다음은 A display of shoes and umbrellas are in a window 에 대한 결과입니다.

이번에는 결과가 좋지 못한 것을 알 수 있습니다.

- 사전 학습된 모델을 바탕으로 Inference만을 했기에 부정확한 결과들도 일부 섞여있음을 확인할 수 있습니다.

- 보다 더 많은 이미지 및 텍스트 Annotation이 있다면 더 좋은 결과가 나오지 않을까 합니다.

'딥러닝 with Python' 카테고리의 다른 글

| [개념정리] 그래프 신경망(Graph Neural Network / GNN) (2) (0) | 2024.08.01 |

|---|---|

| [개념정리] 그래프 신경망(Graph Neural Network / GNN) (1) (0) | 2024.07.31 |

| [딥러닝 with Python] 파이썬 코드로 구현해보는 트랜스포머 (1) | 2024.07.29 |

| [개념정리] 인코딩과 임베딩의 차이(Encoding vs Embedding) (0) | 2024.07.28 |

| [개념 정리] N-gram이란? N-gram 언어 모델이란? (0) | 2024.07.27 |

댓글